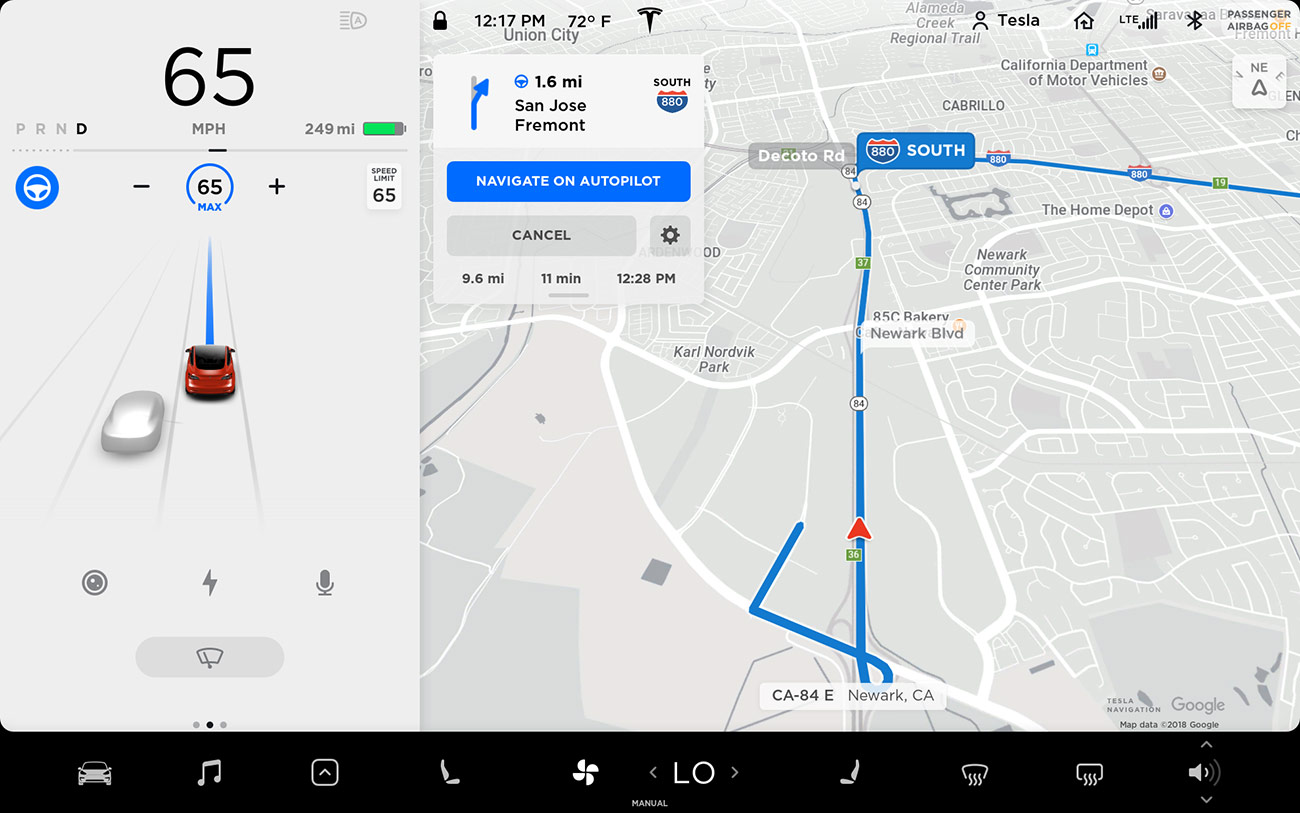

Come ingannare gli algoritmi di Autopilot per la guida autonoma o l’assistenza alla guida messi a punto e istruiti da Tesla con test e feedback raccolti percorrendo milioni di chilometri? Abbiamo già visto che in alcuni casi è sufficiente un pezzo di nastro adesivo, oggi scopriamo che lo si può fare anche con un semplice proiettore. È quanto emerge da uno studio condotto dal team Cyber Security Research Center della Ben-Gurion University israeliana.

Autopilot ingannato da un proiettore

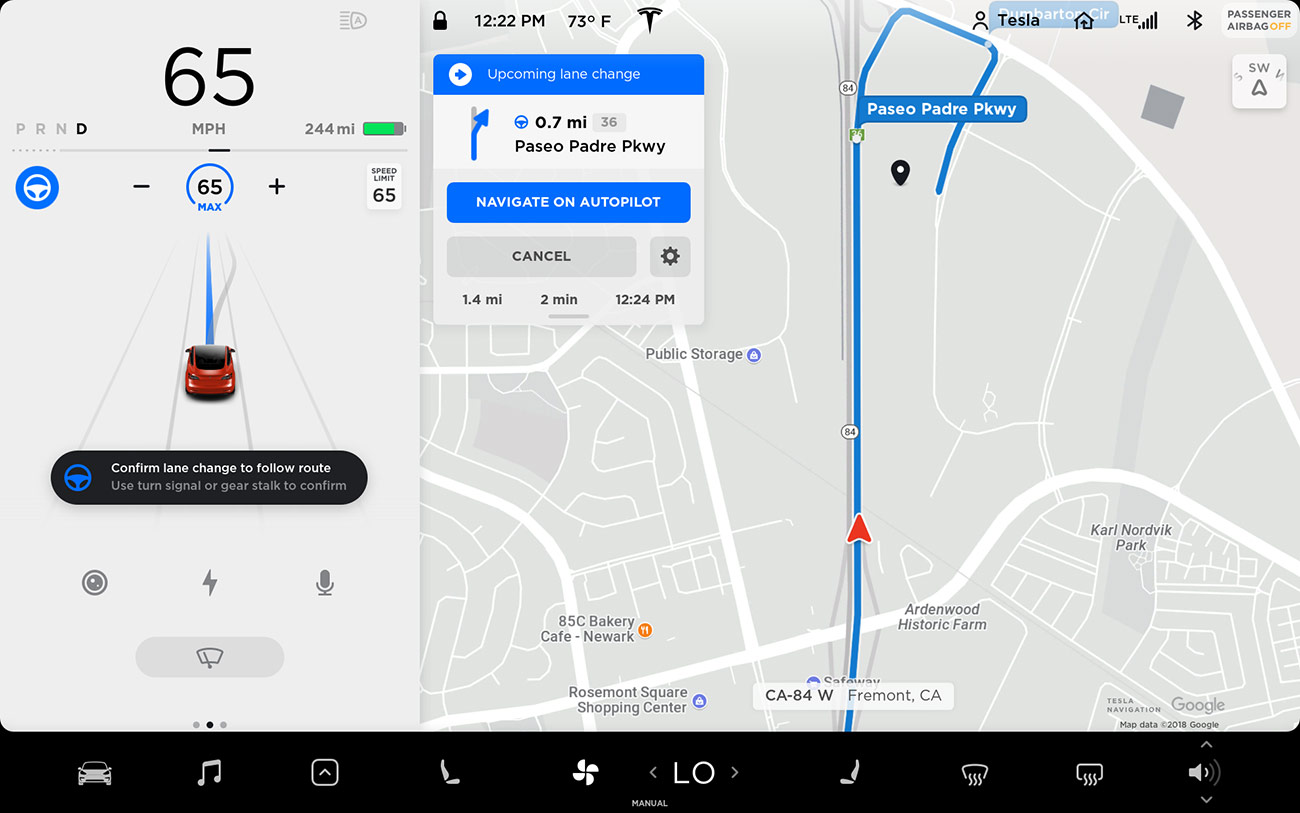

Il video in streaming di seguito mostra i test condotti impiegando una Model X con sistema Mobileye 630 Pro e versione 2.5 del sistema Autopilot. Come prima cosa viene proiettata sull’asfalto la sagoma di una persona e l’IA di bordo la identifica come un pedone, arrestando di conseguenza la propria corsa quando invece non ce ne sarebbe alcun bisogno. Più grave quando il veicolo devia dalla corsia giusta invadendo quella da cui provengono vetture in direzione opposta perché a terra sono proiettate linee fittizie che finiscono col modificare la traiettoria della Tesla.

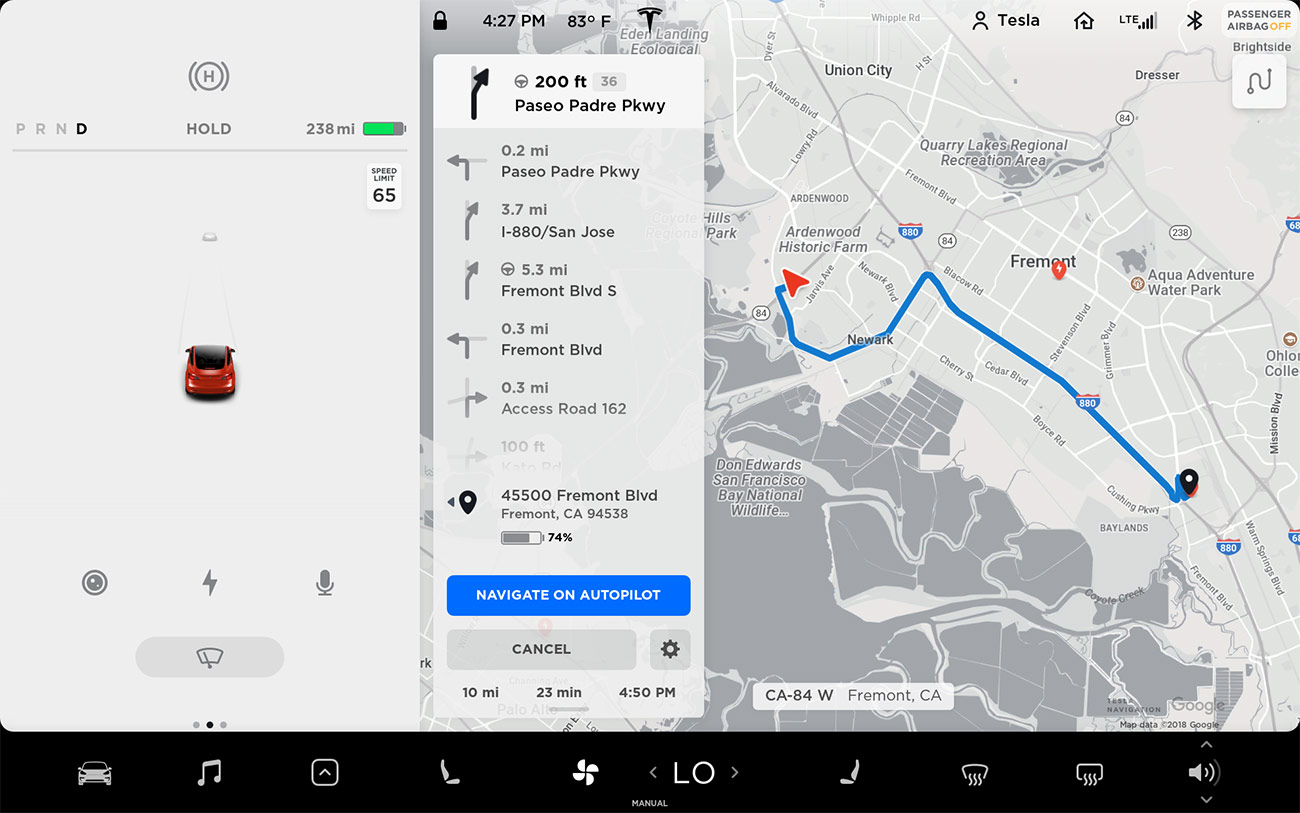

Il terzo e ultimo test prevede l’impiego di un drone che per soli 125 millisecondi proietta su una colonna un finto cartello con limite di velocità a 90 mph (145 Km/h), facendo così compiere un’improvvisa accelerazione all’auto in una zona dove invece è necessario procedere con cautela.

Tutto questo testimonia come la tecnologia attuale ancora necessiti di migliorie e perfezionamenti prima che le self-driving car possano realmente invadere le nostre strade dando così vita come promesso a una nuova era della mobilità, più intelligente, sostenibile e sicura.

Una curiosità: al termine del filmato i ricercatori svelano che la sagoma utilizzata per proiettare l’immagine di un pedone sulla carreggiata è quella di Elon Musk , numero uno di Tesla. Ironia della sorte.

25 02 2020